重现步骤

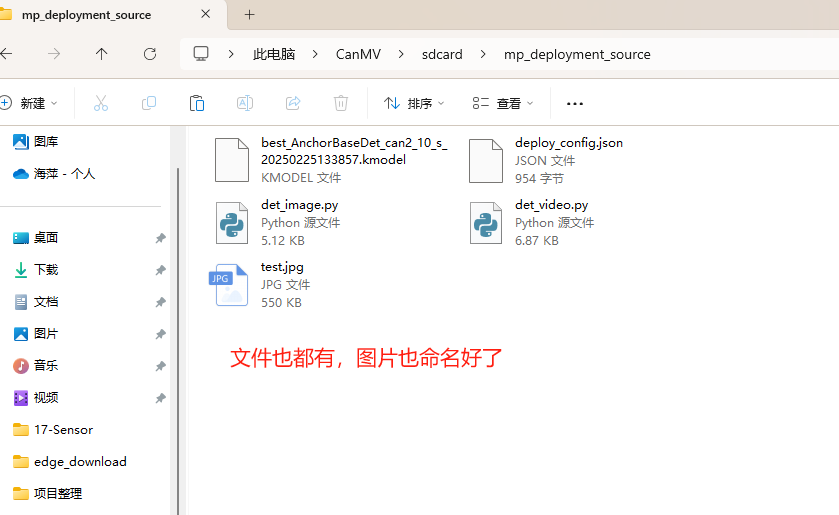

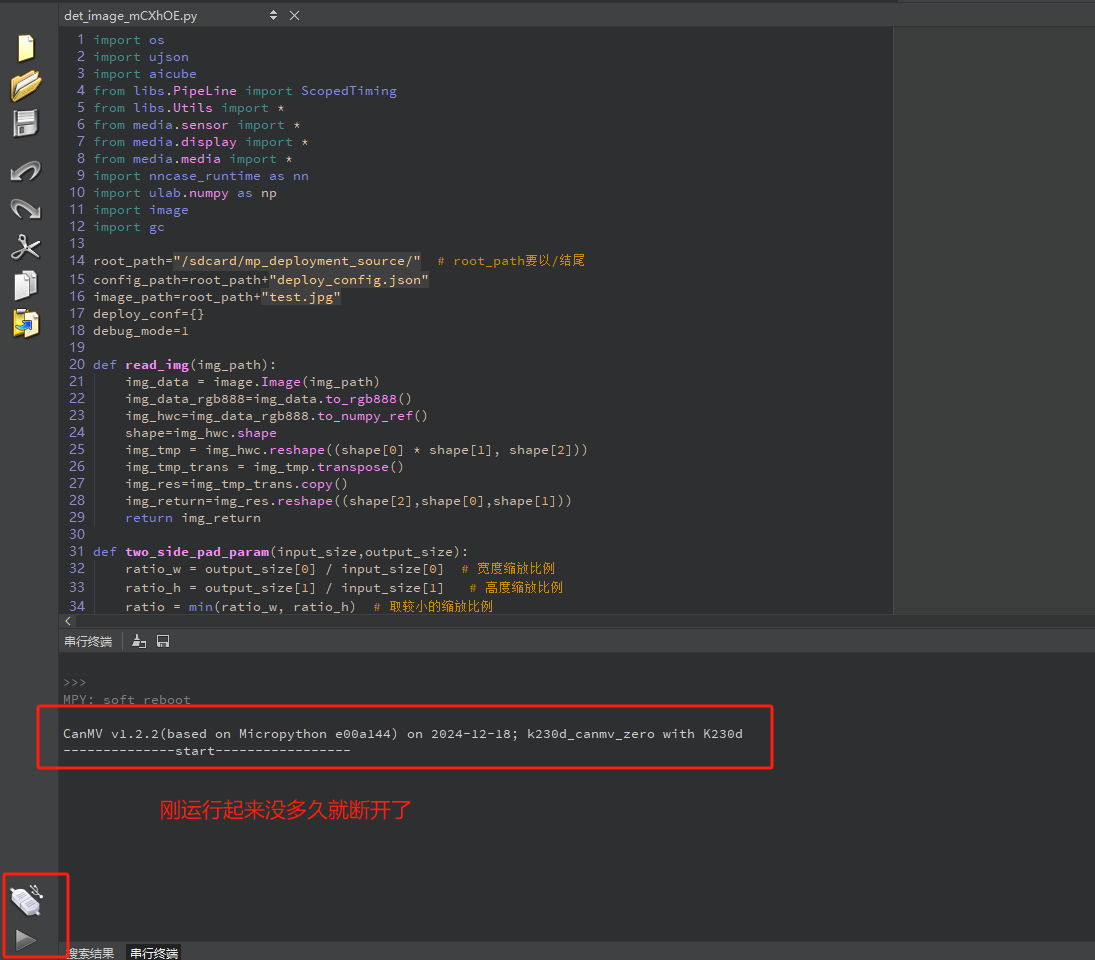

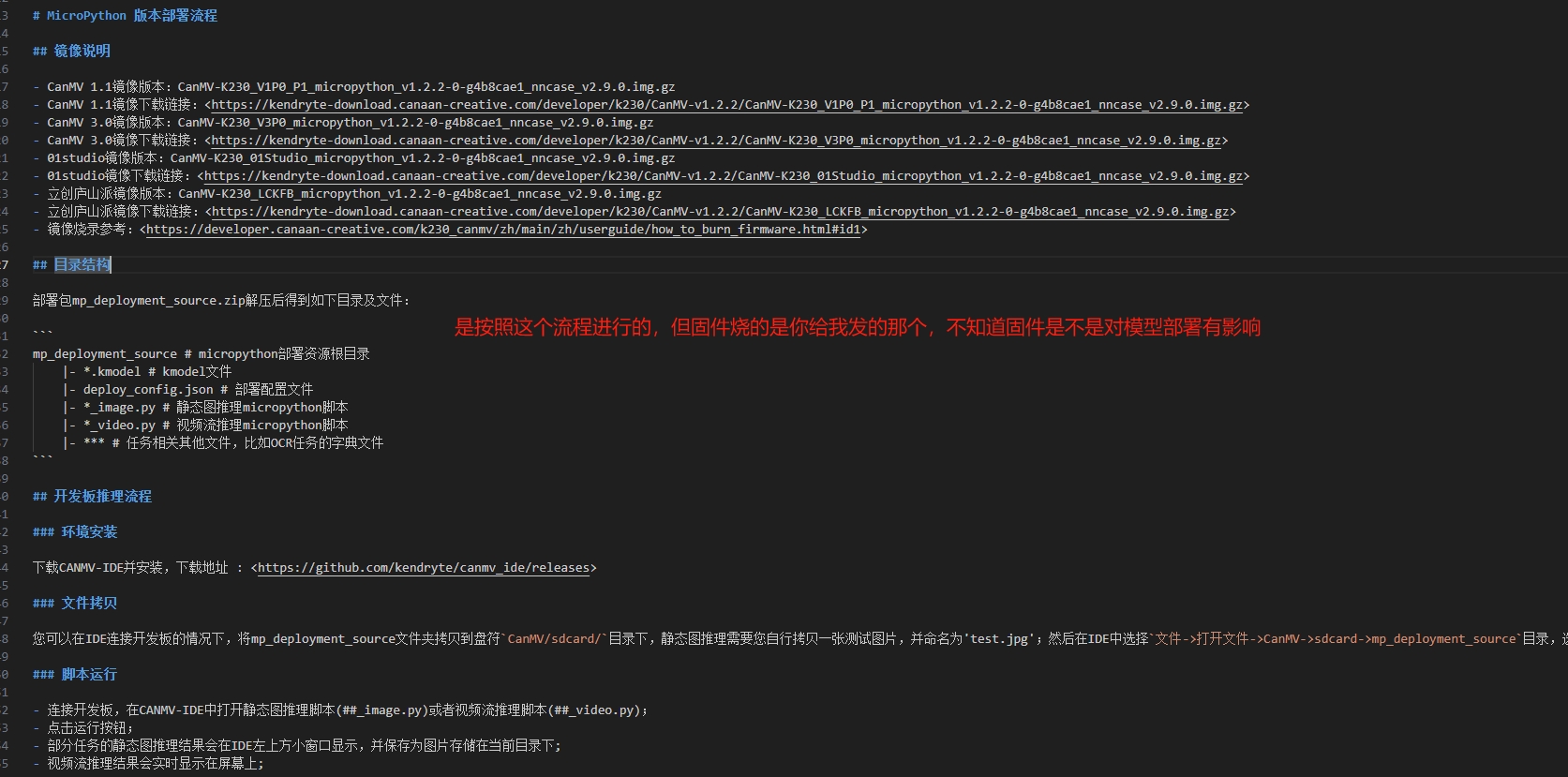

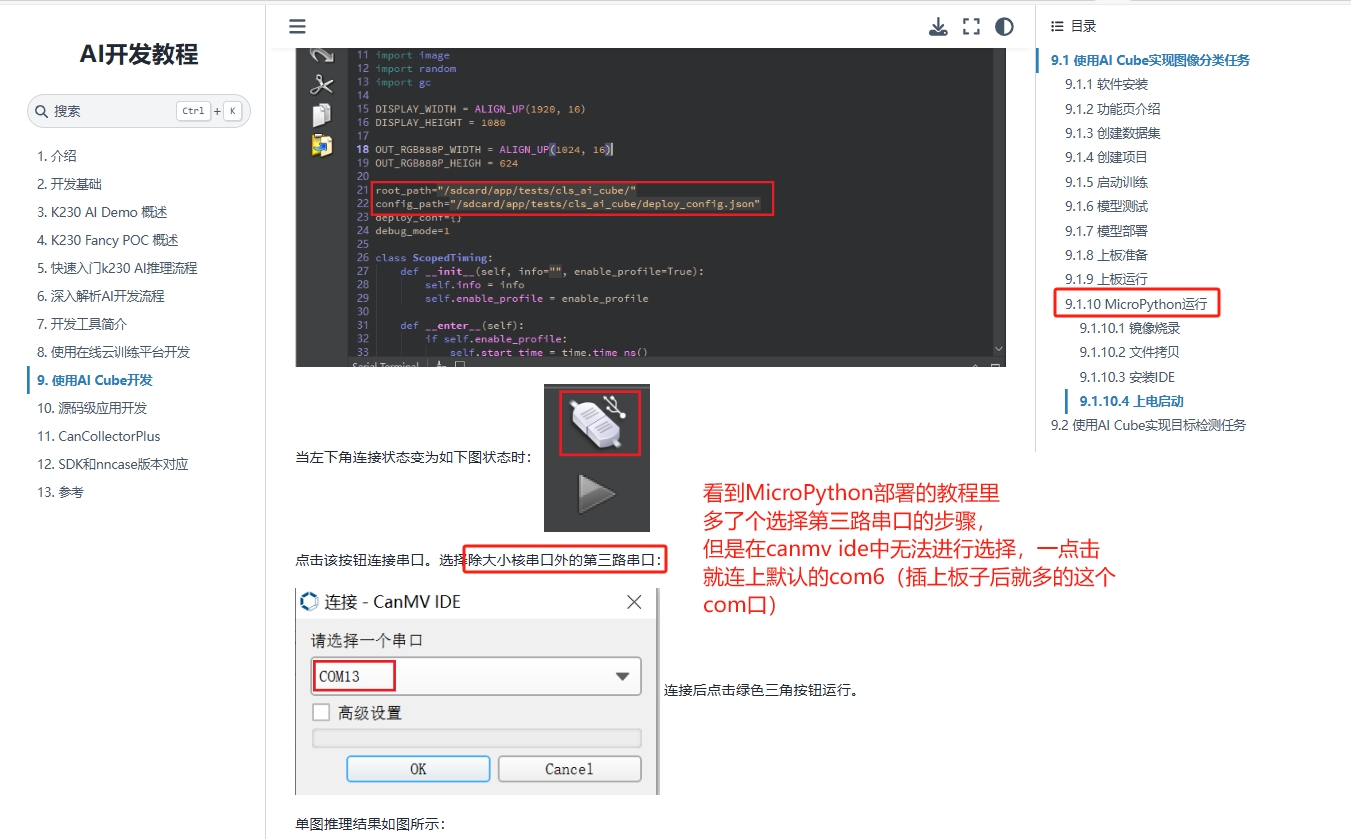

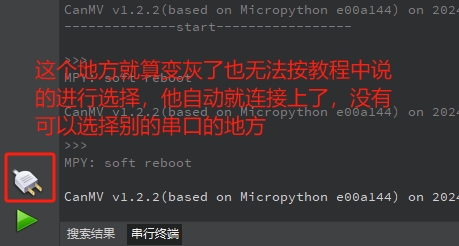

1.按照教程实现MicroPython 版本部署流程,连接上并将文件放到对应位置后,刚运行就断开和canmv ide的连接了(此时用的固件版本是图中推荐的K230D_Zero...)

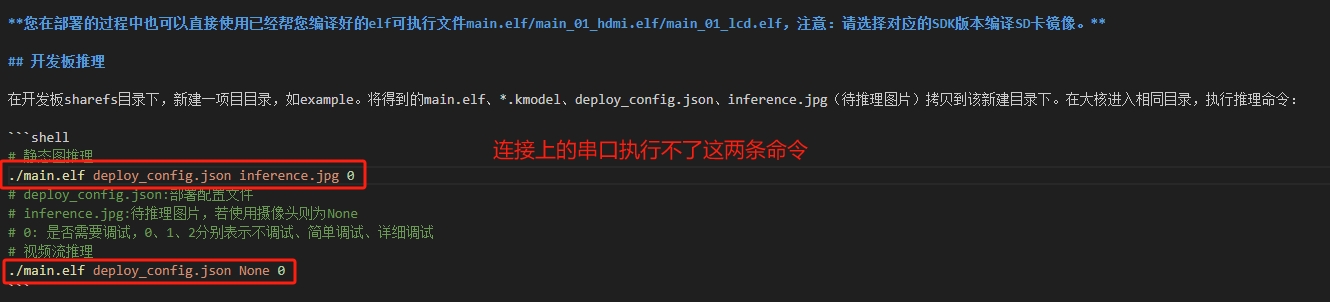

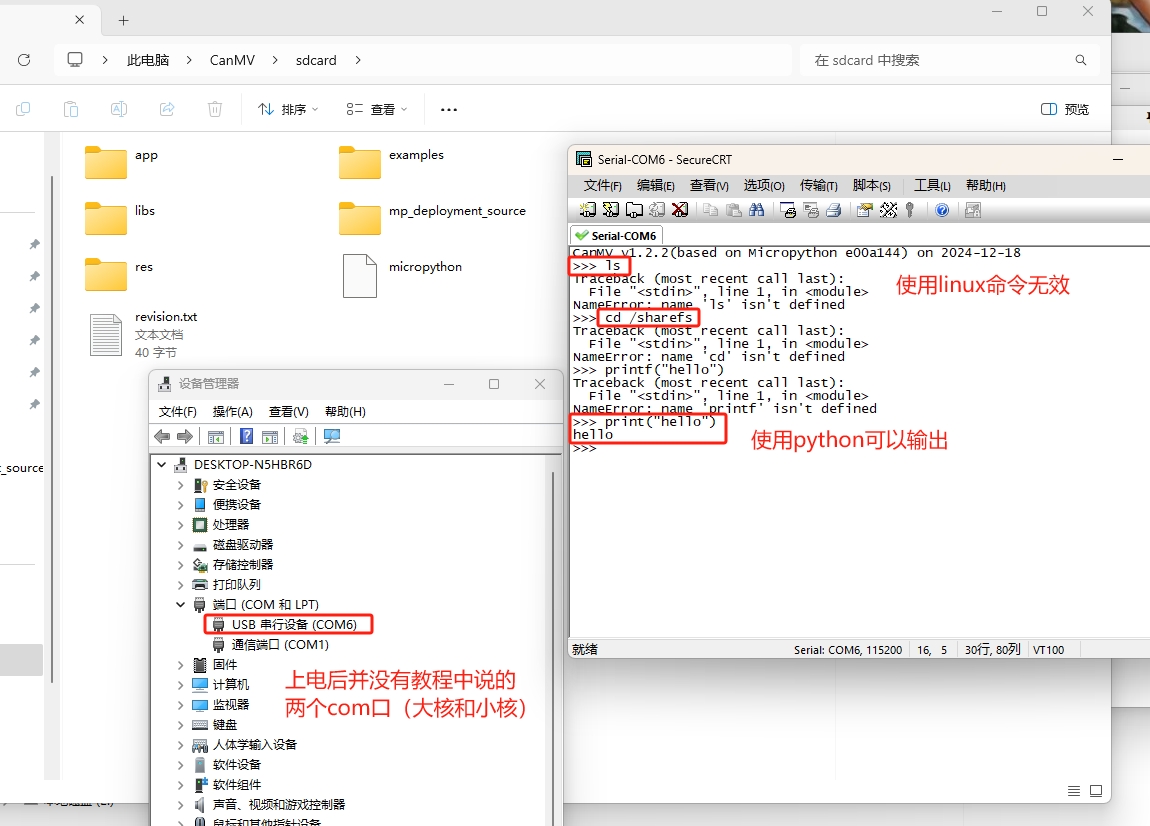

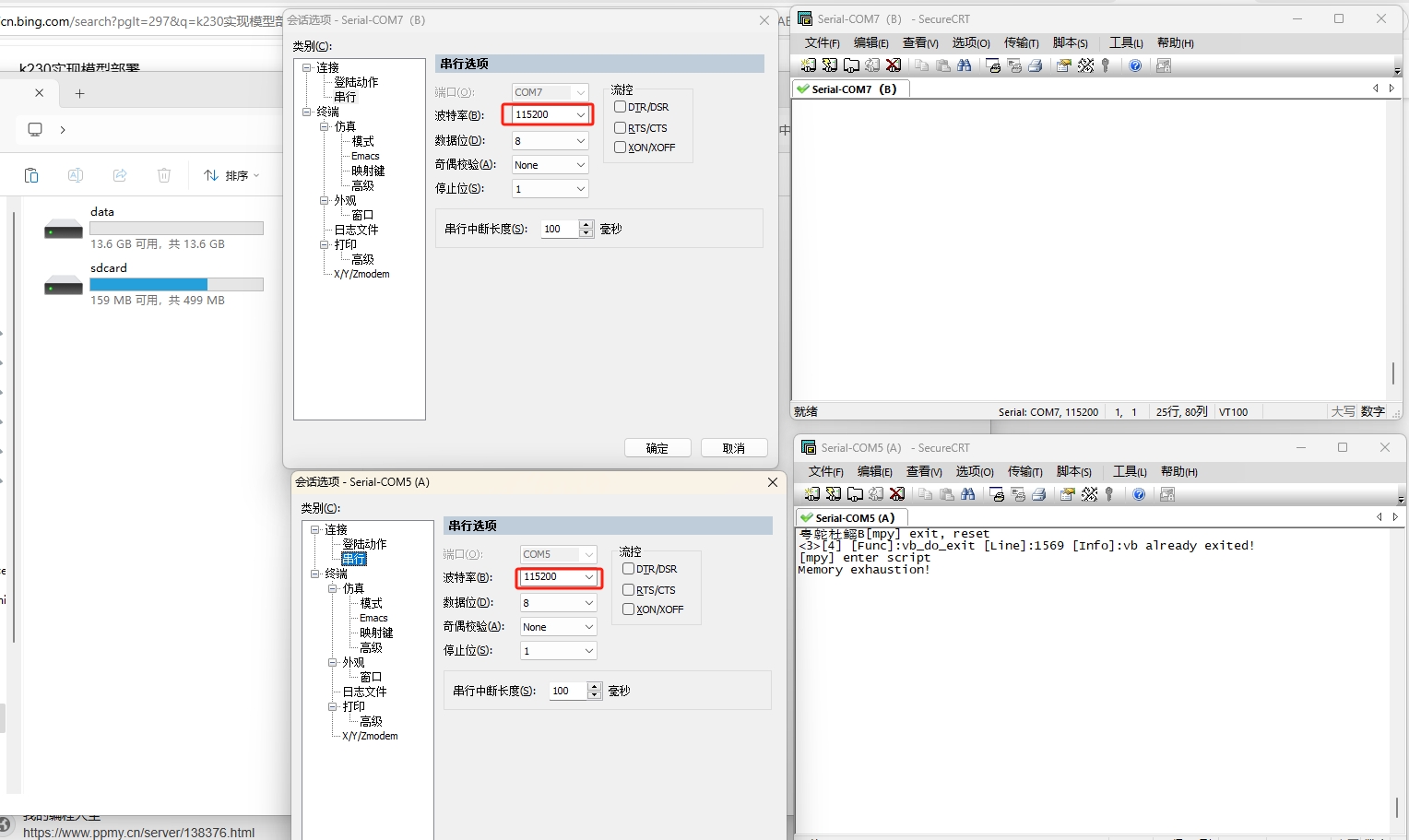

2.按照教程实现C++版本部署流程,大小核这里就无法推进了,无法输入命令

期待结果和实际结果

(1)期待结果:不管按照哪个流程部署完,可以运行给的测试用例,看到结果

(2)实际结果:采用MicroPython部署的无法正常运行,采用C++版本的无法实现部署

尝试解决过程

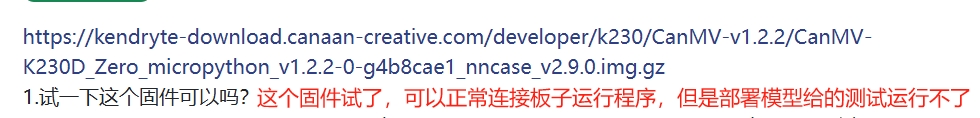

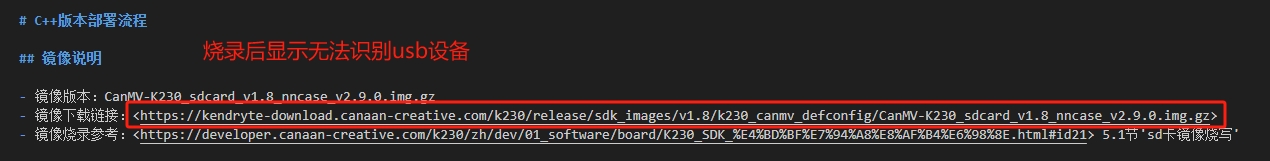

1.考虑到可能是固件不匹配的问题,重新烧录了流程(生成模型后给的readme)中要求的固件,依旧无法成功部署

2.流程中看到MicroPython部署时要选择第三路串口,但并未成功

补充材料

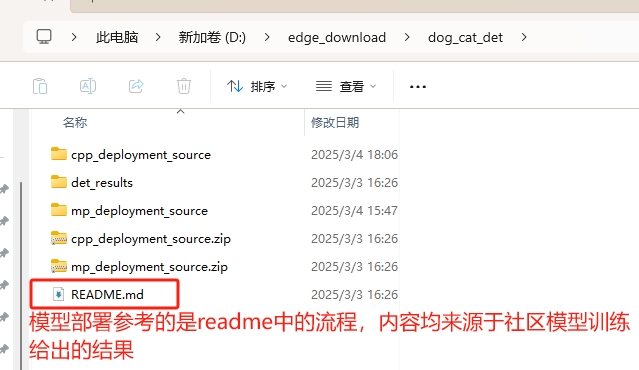

参考的主要流程如下,这个文件内容是在社区官网的模型训练结束后生成的文件压缩包解压后的结果

确认问题

1.K230D应该如何部署模型,具体流程应该是怎样的?因为不管是按照流程给的micropython部署还是cpp部署均未成功,但在操作流程中也并未看到这两个的具体区别。

更新

1.串口打印输出内容如下:

感谢回复!